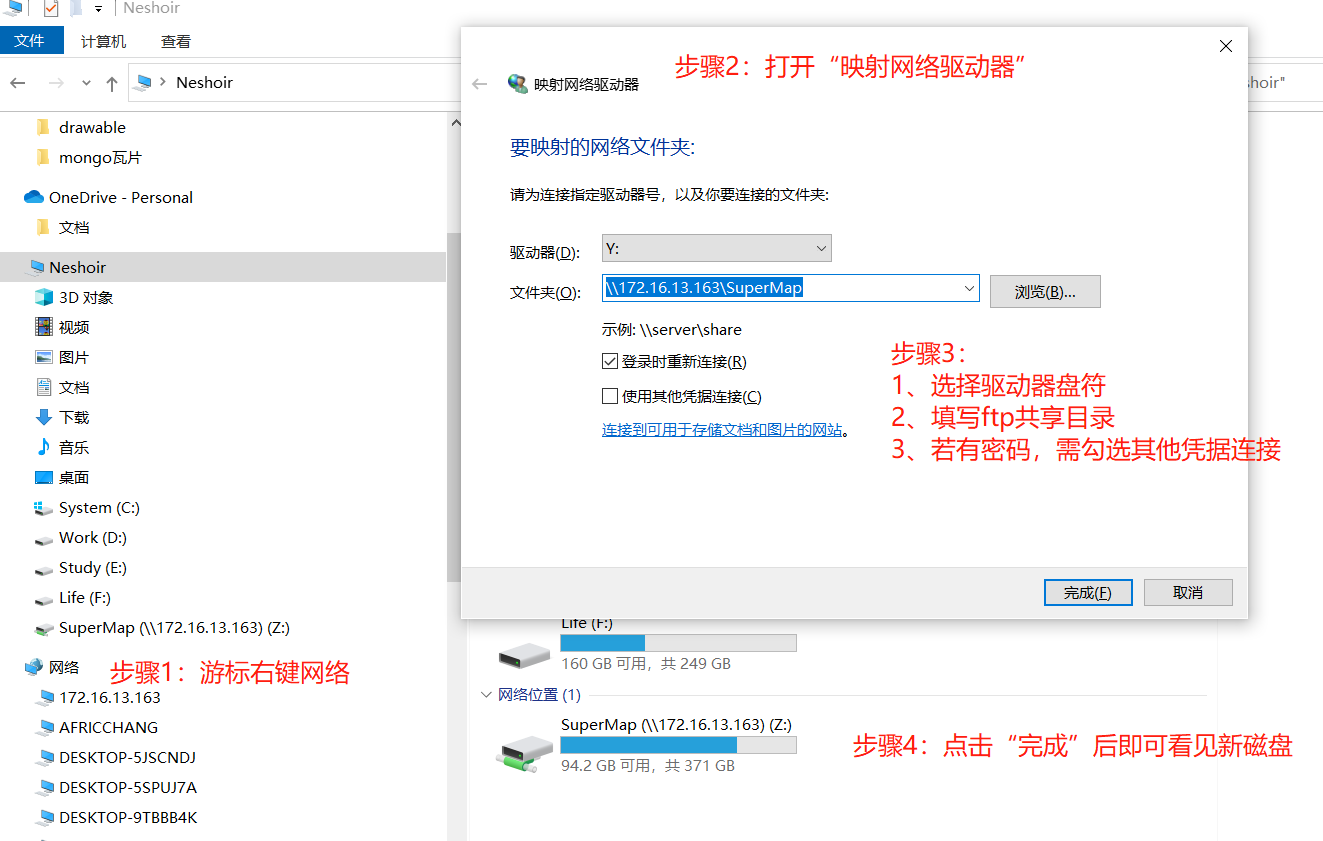

【问题原因】 DSFFeatureRDD的写出实际是借助于Hadoop的接口将分区parquet文件写入到文件系统,Hadoop本身不支持FTP共享目录的读写,需借助于操作系统底层能力。 【解决办法】 假设你根据网上技术文章已搭建好FTP共享目录,示例目录如:\172.16.13.163SuperMap。需要将共享目录映射到磁盘驱动器。步骤如下: 1、打开文件夹管理器,鼠标右键“网络”,点击“映射网络驱动器”; 2、选择驱动器盘符,示例为Z,填写映射目录:\172.16.13.163SuperMap,如果共享目录需要密码,就勾选其他凭据连接,输入账号密码即可。 3、完成后,即可在“网络位置”看见映射的磁盘。 4、整个共享目录已映射为磁盘Z,Spark代码接口的编写如下: val dsf_path = "file:///Z:/test_dsf" val dsfWriteOption = DSFWriteOption(dsf_path) dsfWriteOption.setCompression(Compression.Snappy) DSFWriter.write(JBNTBHTB_DSF, dsfWriteOption) 完整步骤示例如截图。